数据集管理

数据集的创建和数据的上传

见 数据上传。

绑定数据集到容器

在创建容器时,绑定数据可以选择所创建的数据集将其绑定到容器中指定的目录。

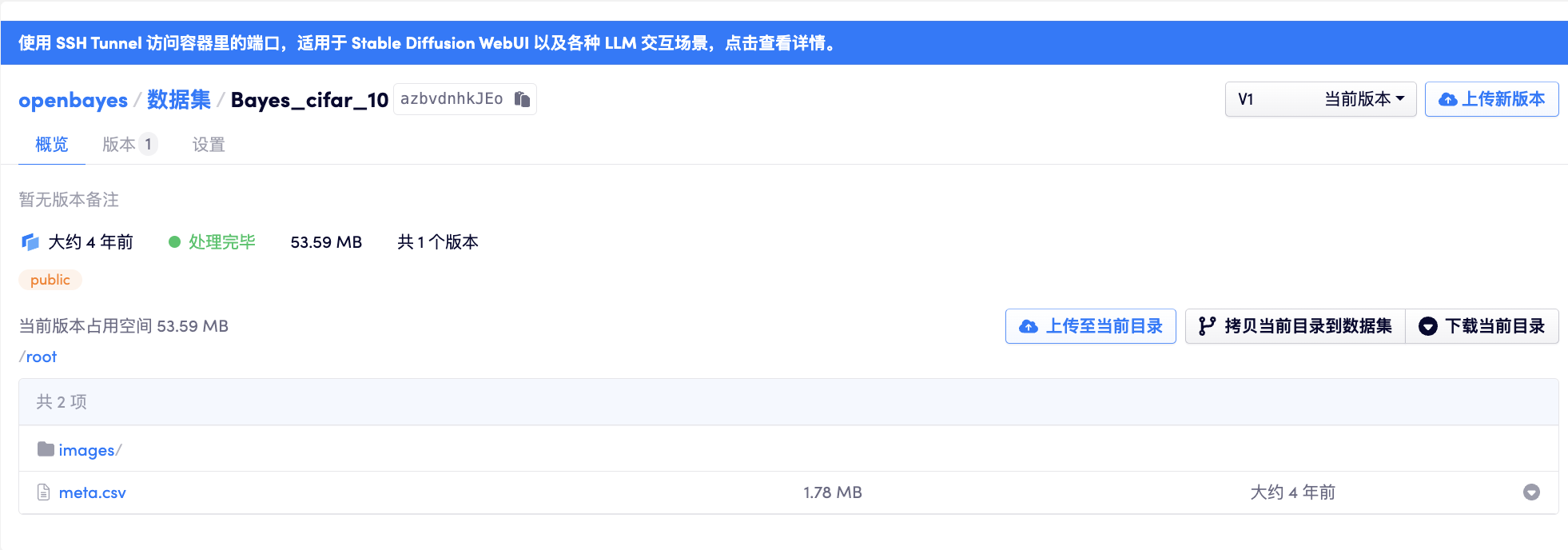

在绑定数据时,需要选定映射到容器中的目录,如下图所示,将 cifar_10 的数据绑定到了 /input0 意味着在容器中通过 /input0 目录就可访问数据集中的内容。

例如 cifar10 数据集中有文件 meta.csv,如果将其绑定在了容器的 /input0 目录,那么可以通过路径 /input0/meta.csv 读取该文件。

在容器详情也可以看到具体容器的绑定目录,如下图所示:

类型的更改

在「数据集」的设置页面下,允许更改数据集的类型:

将其更改为「模型」后,其将在「模型」类型的数据仓库中展示。

数据版本的删除与整个数据集的删除

上文提到,数据集下可以包含多个版本,如果不再需要某一个特定的版本,可以在「版本」列表右侧的「删除当前版本」按钮处进行删除。该版本被删除后,其所占用的存储资源将会被释放。

当然整个数据集如果不再需要后也可以被永久删除,删除后该数据集下的各个版本都将��被删除,也将不再占用用户的存储配额。